人工智能公司OpenAI宣布推出文生視頻大模型Sora

發(fā)布時間:2024-02-18

瀏覽:

人工智能公司OpenAI宣布推出文生視頻大模型Sora

北京時間2月16日凌晨,全球人工智能模型的領(lǐng)先者、AI時代的開創(chuàng)者OpenAI推出了一款能根據(jù)文字指令即時生成短視頻的模型,并將之命名為Sora。Sora的出現(xiàn),讓科技界為之驚嘆。相較于此前生成式AI所生產(chǎn)的動畫內(nèi)容,Sora展示的全新影像畫面讓人瞠目結(jié)舌,其所公示的影像光影、細節(jié)等,讓人直呼震撼,真可謂AI版的“神筆馬良”。

OpenAI官網(wǎng)

早在2022年11月30日,OpenAI發(fā)布名為ChatGPT的全新聊天機器人模型時,大多數(shù)人就已經(jīng)預(yù)料到AI將引發(fā)一場新的技術(shù)革命。Sora的推出意味著什么,可能并不像人們想象的那么簡單。多名業(yè)內(nèi)專家告訴南方+記者,目前的Sora仍未完全進化,因此會存在“不可靠”的地方,但毋庸置疑,AI的步伐會越來越快。

從文本到影像

“AI的一大步,但還無法稱為跨越式發(fā)展”

北京大深圳研究院5G課題組組長、廣東省前沿科技研究院院長胡國慶認為,根據(jù)目前Sora官方所發(fā)布的樣片來看,其將文本直接生成圖像的能力在某種程度上確實能達到以假亂真的效果,這對藝術(shù)家、電影制作人等制作視頻的人來說,算得上一個很大的進步。同時,相較于此前的AI產(chǎn)品,這無疑是一次巨大的飛躍。

然而,將文本生成60秒短視頻的能力,實際上之前已有其他模型能夠?qū)崿F(xiàn)幾秒鐘的視頻。

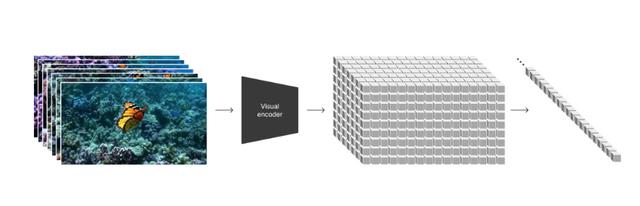

“要說這是跨越式的進步,目前來看,還為時過早?!焙鷩鴳c指出,根據(jù)OpenAI發(fā)布的視頻來看,AI通過將文本逐幀生成圖像,再串聯(lián)組合生成視頻的技術(shù)路線,為其他模型訓(xùn)練從文本到影像的能力提供了一個很好的思路。

官方所公布的原理圖釋。

同時,目前官方也公布了一些Sora的“硬傷”。騰訊機器學(xué)習(xí)平臺部專家工程師姚軍解釋道,因為其模型不是依靠內(nèi)在的物理仿真引擎,所以所生成的視頻常常顯得“不可靠”,會出現(xiàn)不符合真實物理規(guī)律的地方,這是當(dāng)下這類依賴大規(guī)模數(shù)據(jù)驅(qū)動的大規(guī)模參數(shù)模型迭代的技術(shù)思路難以根除的問題。

在姚軍看來,目前該應(yīng)用所能使用的場景仍比較有限?!皬脑砩弦膊浑y得出,這類模型不具備世界模型,沒有真正的一套知識框架內(nèi)核,只是依賴數(shù)據(jù)中體現(xiàn)的‘大數(shù)原理’,與現(xiàn)實世界有一定的重合,但遠達不到‘世界模型’的門檻?!?/span>

AGI實現(xiàn)可能縮短至一年?

“謹慎看待,但時間會大幅縮短”

針對此次Sora所帶來的討論,360創(chuàng)始人周鴻祎在社交網(wǎng)絡(luò)上發(fā)布看法,他甚至認為,Sora的誕生意味著AGI(通用人工智能)實現(xiàn)可能從10年縮短至一兩年。

談到Sora最大的優(yōu)勢,周鴻祎表示,以往文字視頻軟件都是在2D平面上對圖形元素進行操作,可以把視頻看成多個真實圖片的組合,并沒有真正掌握這個世界的知識。但Sora產(chǎn)生的視頻里,它能像人一樣理解坦克是有巨大沖擊力的,坦克能撞毀汽車,而不會出現(xiàn)汽車撞毀坦克這樣的情況,“一旦人工智能接上攝像頭,把所有的電影都看一遍,把YouTube和TikTok的視頻都看一遍,對世界的理解將遠遠超過文字學(xué)習(xí)。一幅圖勝過千言萬語,而視頻傳遞的信息量又遠遠超過一張圖,這就離AGI真的就不遠了,不是10年20年的問題,可能一兩年很快就可以實現(xiàn)?!?/span>

然而,業(yè)內(nèi)專家則向南方+記者表示,相信AI發(fā)展的速度會越來越快,但僅一年內(nèi)是否可以實現(xiàn)AGI仍需謹慎看待。胡國慶表示,此前OpenAI的總裁確實提到過2024年會重點發(fā)展AGI,但是,能否在一年內(nèi)實現(xiàn),仍屬于未知?!癝ora問世后,相信谷歌等科技企業(yè)也會迅速跟進,預(yù)計今年各家都會推出類似的公測版本,越多廠商競爭,意味著該領(lǐng)域也會加速走向成熟?!?/span>

對于公眾何時能夠大規(guī)模使用此類產(chǎn)品,姚軍則告訴記者,“預(yù)計很快?!币姳硎荆谖匆姷絿烂C論文的情況下,僅憑感覺目前Sora是在吸取了很多大語言模型和文生圖的迭代經(jīng)驗,部分解決了訓(xùn)練數(shù)據(jù)的約束,據(jù)說是用到了游戲引擎生成的視頻數(shù)據(jù),同時,由于傳聞該模型的規(guī)模并不大,所以其成果預(yù)計可以很快進行應(yīng)用落地。

但有一件事毋庸置疑,后續(xù)該模型的優(yōu)化速度會越來越快,就像當(dāng)時文生圖技術(shù)所出現(xiàn)后一樣,一個季度一次升級,一年一個大變樣。

影視行業(yè)會因AI受沖擊?

業(yè)內(nèi)人士:AI生成成本低,但“比較假”

由于Sora所具備的影像能力,讓人不得不聯(lián)想AI產(chǎn)業(yè)是否會沖擊到影視行業(yè),對此,記者聯(lián)系到北京一家影視公司相關(guān)負責(zé)人心一(化名),在她看來,相比與此前的AI影像,此次Sora帶來的畫質(zhì)內(nèi)容讓人驚艷,但是對于直接參與到影視生產(chǎn)過程中,卻并不看好。

“單純從畫質(zhì)上來說,sora呈現(xiàn)出的大部分視頻不論是清晰度或者畫面細節(jié)都讓人驚嘆,但與當(dāng)下主流影視作品卻相距甚遠?!毙囊唤忉尩?,因為當(dāng)下影視作品中很少有單個鏡頭呈現(xiàn)的作品,Sora能給到觀眾相對真實感更強的動物、風(fēng)景等畫面,但涉及人物和城市的鏡頭還是讓人感覺到一種虛擬感,這種虛擬感不是畫面質(zhì)量的問題,而是和實拍的畫面質(zhì)感有一定的差距,“簡而言之,就是看起來還是比較假?!?/span>

OpenAI所發(fā)布的Sora所生成的影像。

相較于傳統(tǒng)影視行業(yè),AI生產(chǎn)成本上確實遠低于傳統(tǒng)實拍或者后期制作的特效鏡頭。心一表示,例如女生在街道上走路的那段視頻,如果要實拍的話,場地、置景、燈光、攝影、演員及后期特效制作等都是需要考慮的問題,攝制成本規(guī)模會從幾十人到幾百人不等。但是這些都是針對Sora生產(chǎn)出的某一個畫面的成本對比,具體Sora是否能完成連續(xù)性的長篇幅畫面仍需驗證,例如此前的Midjourney文生圖產(chǎn)品,它會給你一些意外之喜,但無法準確呈現(xiàn)用戶所期待的畫面。

至于網(wǎng)友所熱議的,是否擔(dān)心影視業(yè)被AI搶飯碗?對此,心一則表示并不擔(dān)心,“要用AI去拍電視劇,實操上還會面臨AI產(chǎn)品的可控性、畫面和視頻版權(quán)等等問題?!?/span>

想要AI“拍出”人們所期待的畫面,仍需讓子彈再飛一會。